【2024年3月更新】10分でわかる Google の新しい大規模言語モデル Gemma (ジェンマ) の基本情報

2024年2月21日、 Google が新しい大規模言語モデルである「 Gemma (ジェンマ ※1) 」を発表しました。 このモデルは、オープンモデルとしてリリースされているため、開発者や研究者は独自のカスタマイズモデルを構築・再配布(※2)を行うことができます。元々、 Google は Transformer、TensorFlow 等、オープンコミュニティへの貢献に積極的であり、今回のリリースはその流れに沿った活動の一環であると考えています。

※1 Gemma はラテン語で「宝石」を意味しています。

※2 利用規約を見ると、商業利用と配布が許可されています。

Gemma (ジェンマ)の基本情報

2つのサイズのモデルを提供

Gamma には2つのサイズが用意されていて、この2つのモデルは事前トレーニング(※3)が実施されており、開発者はそれをベースにさらなるカスタマイズも可能です。7Bの方が2Bと比較した時に、パラメータ数が優れているため、ベンチマークでは高いパフォーマンスを計測しています。ただ、性能が優れているからといって7B一択というわけではなく、用途やプラットフォームに応じて、2つのサイズからどちらかを選択すると良いでしょう。

| モデルサイズ | パラメーター数 | 対象プラットフォーム |

|---|---|---|

| Gamma 2B | 20億 | モバイルデバイス ノートパソコン |

| Gamma 7B | 70億 | デスクトップコンピュータ 小規模サーバー |

※3 Gemma は Tensor Processing Unit (TPU) の最新バージョンである TPU v5e を利用してトレーニングされています

Gemma のパフォーマンス

MMLU とは、事前トレーニング中にLLM(大規模言語モデル)が習得した知識の幅と問題解決能力を測定するベンチマークテストになりますが、 Google によると Gemma-7b はこのテストにおいて、 META社 が公開した LLAMA-2 よりも高いベンチマークを計測したとのことです。詳しい技術レポートは、Web で公開されているコチラのPDF(英文)をご参考ください。

Gemma はどこで利用可能?

開発者・研究者・個人が所有するパソコン

Gemma は特定のプラットフォーム上でのみ動作するモデルではありません。開発者・研究者は、自分自身のマシンから Gemma を動作させることが可能です。

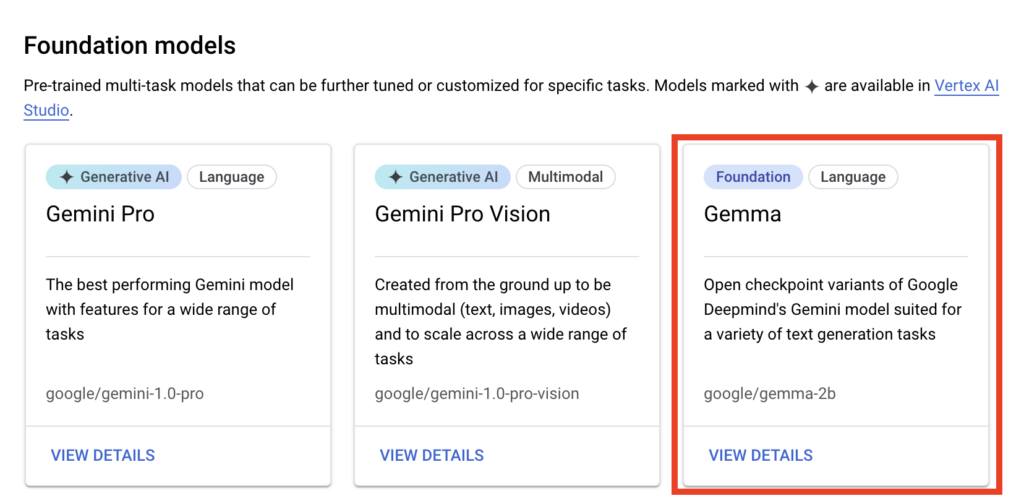

Google Cloud Platform ( Vertex AI / GKE )

Gemma は Vertex AI の Model Garden に追加されたため、 PaLM2 や Gemini と並んで Vertex AI で選択可能なモデルの一つになりました。これにより、開発者は Vertex AI でカスタマイズしたモデルを、GKE ( Google Kubernetes Engine ) 上で実行することができるようになります。

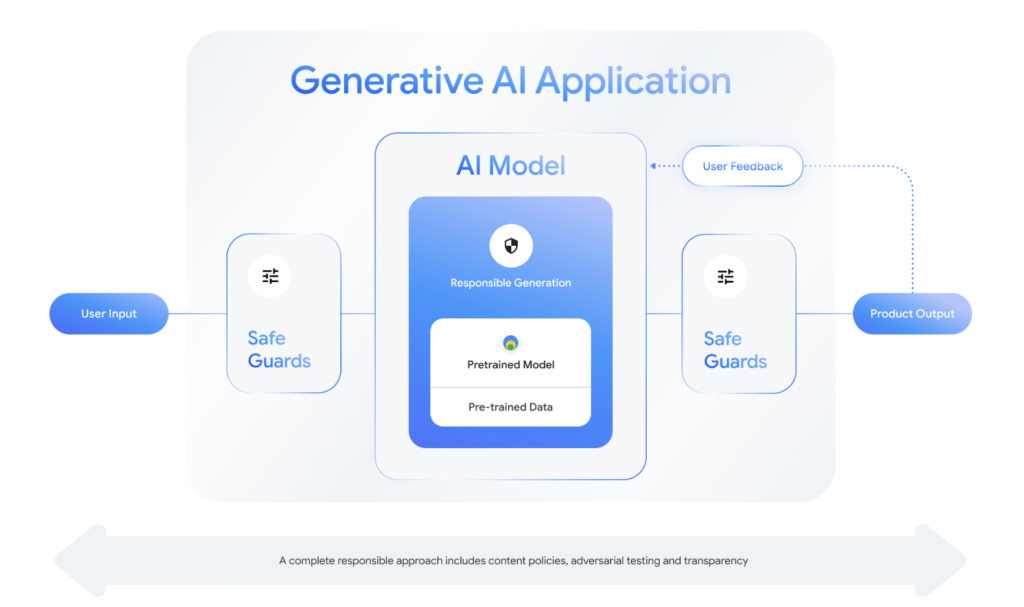

安全性のサポート

Google は AI を提供する企業として「AI原則」を掲げており、社会にとって有益であり安全性のあるAIの提供を意識しています。そのため、 Google は Gemma をただ単にオープンモデルとして公開するだけでなく、安全性を担保するためのデバッグツールも提供しています。ツールについての詳細はコチラをご参考ください。

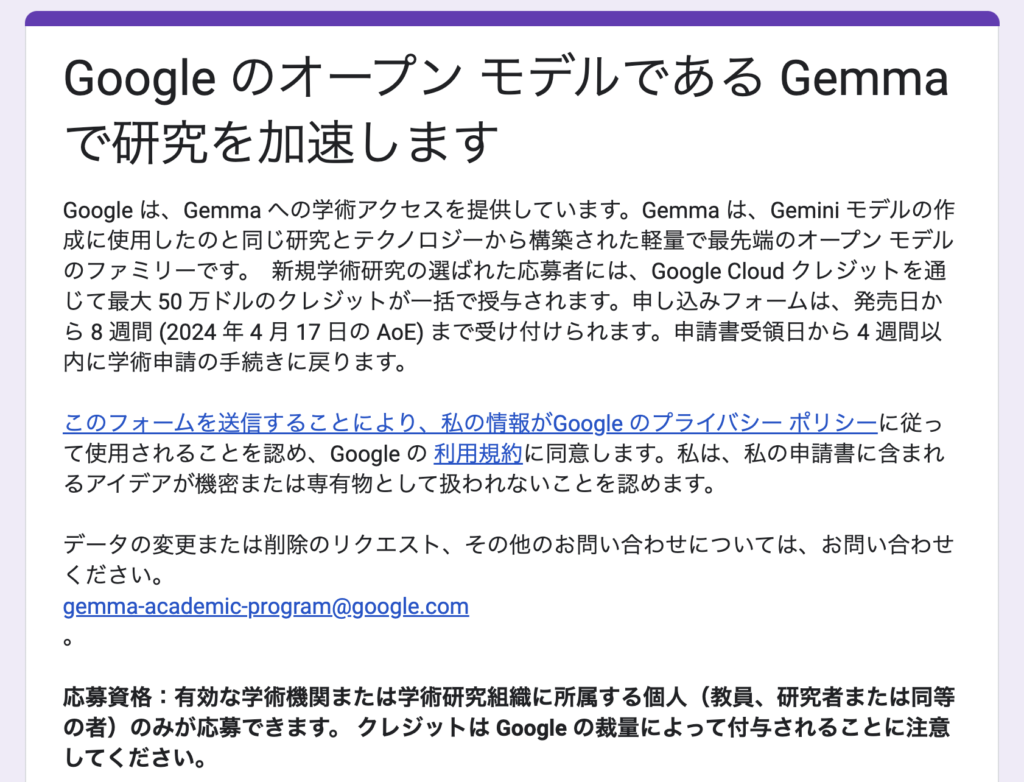

最大50万ドルの無料クレジットを獲得可能?

Google は研究開発のために無料クレジットの提供を実施すると発表しています。これは Google Cloud 用の無料クレジットであり、研究自体に対して研究開発費を支援するものではありません。申請についてはコチラのフォームから手続きが可能です。

まとめ

今回ご紹介した Gemma モデルのまとめは以下の通りです。情報は随時更新予定なので、興味がある方は是非チェックをよろしくお願いします!

| 公開日 | 2024/02/21 |

| 提供モデル | Gemma |

| 読み方 | ジェンマ |

| 2つのモデルサイズ | 2B(20億パラメータ) 7B(70億パラメータ) |

| 実行可能な環境 | Google Cloud Platform ( Vertex AI / GKE ) 開発者のパソコン |

| 無料クレジット | 最大50万ドル |